图像处理经典网络

【注】本文采用 PyTorch 框架,基于 Fashion-MNIST 数据集。

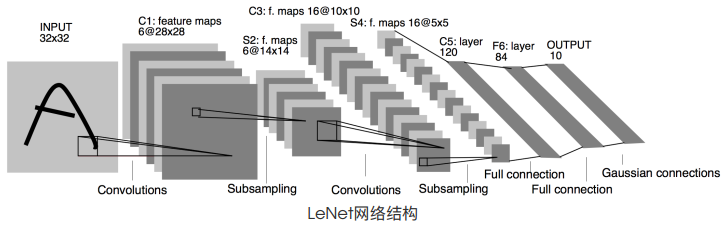

1. LeNet

LeNet分为卷积层块和全连接层块两个部分。

1.1 卷积层块

-

卷积层块⾥的基本单位是卷积层后接最⼤池化层:卷积层⽤来识别图像⾥的空间模式,如线条和物体局部,之后的最⼤池化层则⽤来降低卷积层对位置的敏感性。

-

在卷积层块中:每个卷积层都使⽤ 的窗⼝,并在输出上使⽤ sigmoid 激活函数。第⼀个卷积层输出通道数为 6 ,第⼆个卷积层输出通道数则增加到 16 。这是因为第⼆个卷积层⽐第⼀个卷积层的输⼊的⾼和宽要⼩,所以增加输出通道使两个卷积层的参数尺⼨类似。

-

卷积层块的两个最⼤池化层的窗⼝形状均为 ,且步幅为 2 。由于池化窗⼝与步幅形状相同,池化窗⼝在输⼊上每次滑动所覆盖的区域互不重叠。

-

卷积层块的输出形状为(批量⼤⼩, 通道, ⾼, 宽)。

1.2 全连接层块

-

当卷积层块的输出传⼊全连接层块时,全连接层块会将⼩批量中每个样本变平(flatten)。也就是说,全连接层的输⼊形状将变成⼆维,其中第⼀维是⼩批量中的样本,第⼆维是每个样本变平后的向量表示,且向量⻓度为通道、⾼和宽的乘积。

-

全连接层块含 3 个全连接层。它们的输出个数分别是 120、84 和 10 ,其中 10 为输出的类别个数。

1.3 PyTorch 实现

1 | |

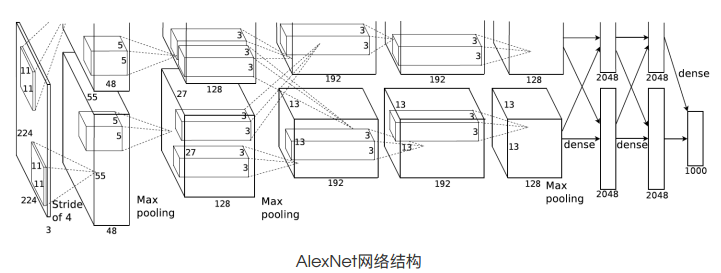

2. AlexNet

AlexNet 与 LeNet 的设计理念⾮常相似,但也有显著的区别。

2.1 网络结构

-

AlexNet 包含 8 层变换,其中有 5 层卷积和 2 层全连接隐藏层,以及 1 个全连接输出层。

-

AlexNet 将 sigmoid 激活函数改成了更加简单的 ReLU 激活函数。

-

AlexNet 通过 Dropout 来控制全连接层的模型复杂度。

2.2 PyTorch 实现

1 | |

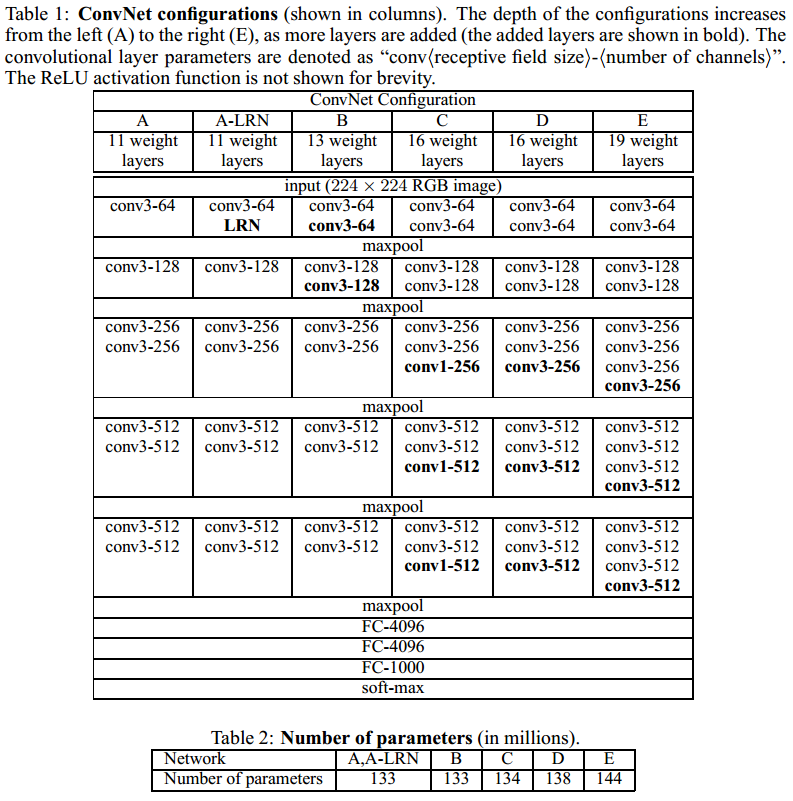

3. VGG

3.1 网络结构

-

VGG块的组成规律是:连续使⽤数个相同的填充为1、窗⼝形状为 的卷积层后接上⼀个步幅为2、窗⼝形状为 的最⼤池化层。

-

对于给定的感受野(与输出有关的输⼊图⽚的局部⼤⼩),采⽤堆积的⼩卷积核优于采⽤⼤的卷积核,因为可以增加⽹络深度来保证学习更复杂的模式,⽽且代价还⽐较⼩(参数更少)。在 VGG 中,使⽤了 3 个 卷积核来代替 卷积核,使⽤了 2 个 卷积核来代替 卷积核。

3.2 PyTorch 实现

以下实现了一个简单的 VGG-11 网络。

1 | |

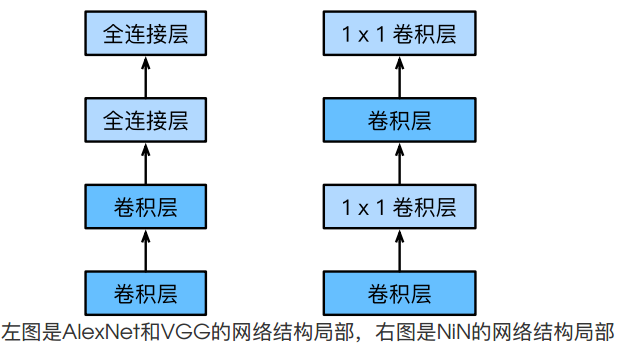

4. NiN

4.1 网络结构

-

NiN 使⽤ 的卷积层来替代全连接层。

-

NiN 块是 NiN 中的基础块。它由⼀个卷积层加两个充当全连接层的 卷积层串联⽽成。其中第⼀个卷积层的超参数可以⾃⾏设置,⽽第⼆和第三个卷积层的超参数⼀般是固定的。

-

NiN 去掉了 AlexNet 最后的 3 个全连接层,取⽽代之地,NiN 使⽤了输出通道数等于标签类别数的 NiN 块,然后使⽤全局平均池化层对每个通道中所有元素求平均并直接⽤于分类。

4.2 PyTorch 实现

1 | |

5. GoogLeNet

5.1 网络结构

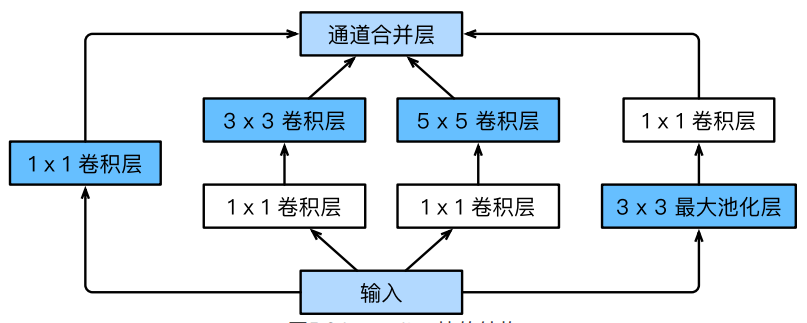

GoogLeNet 引入了并行连结的网络结构,其基础卷积块称为 Inception 块,其结构如下:

- Inception 块⾥有 4 条并⾏的线路。

- 前 3 条线路使⽤窗⼝⼤⼩分别是 1 \time 1、 和 的卷积层来抽取不同空间尺⼨下的信息,其中中间 2 个线路会对输⼊先做 卷积来减少输⼊通道数,以降低模型复杂度。

- 第 4 条线路则使⽤ 最⼤池化层,后接 卷积层来改变通道数。

- 4 条线路都使⽤了合适的填充来使输⼊与输出的⾼和宽⼀致。最后我们将每条线路的输出在通道维上连结,并输⼊接下来的层中去。

GoogLeNet 跟 VGG ⼀样,在主体卷积部分中使⽤ 5 个模块(block),每个模块之间使⽤步幅为2的 最⼤池化层来减⼩输出⾼宽。

5.2 PyTorch 实现

1 | |

6. ResNet

6.1 网络结构

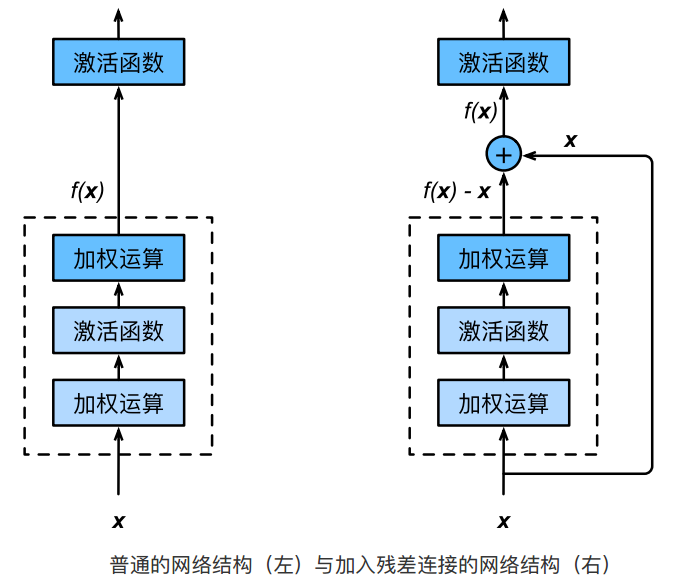

ResNet 引入了恒等映射的跨层连结,其基础块称为残差块(Residual),如下所示:

- ResNet 沿⽤了 VGG 全 卷积层的设计。残差块⾥⾸先有 2 个有相同输出通道数的 卷积层。每个卷积层后接⼀个批量归⼀化层和 ReLU 激活函数。

- 然后我们将输⼊跳过这两个卷积运算后直接加在最后的 ReLU 激活函数前。这样的设计要求两个卷积层的输出与输⼊形状⼀样,从⽽可以相加。

- 如果想改变通道数,就需要引⼊⼀个额外的 卷积层来将输⼊变换成需要的形状后再做相加运算。

GoogLeNet 在后⾯接了 4 个由 Inception 块组成的模块。ResNet 则使⽤ 4 个由残差块组成的模块,每个模块使⽤若⼲个同样输出通道数的残差块。

6.2 PyTorch 实现

1 | |

7. DenseNet

7.1 网络结构

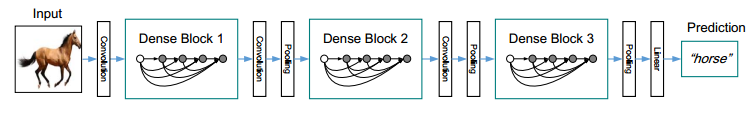

DenseNet 的主要局部结构如下:

DenseNet 网络结构如下:

DenseNet 的基础块称为稠密块(DenseBlock)和过渡层(TransitionLayer):

- 前者定义了输⼊和输出是如何连结的,后者则⽤来控制通道数,使之不过⼤。

- 稠密块由多个「批量归一化、激活和卷积」结构构成,其中卷积块的通道数控制了输出通道数相对于输⼊通道数的增⻓,因此也被称为增⻓率(growth rate)。

- 过渡层通过 卷积层来减⼩通道数,并使⽤步幅为 2 的平均池化层减半⾼和宽,从⽽进⼀步降低模型复杂度。

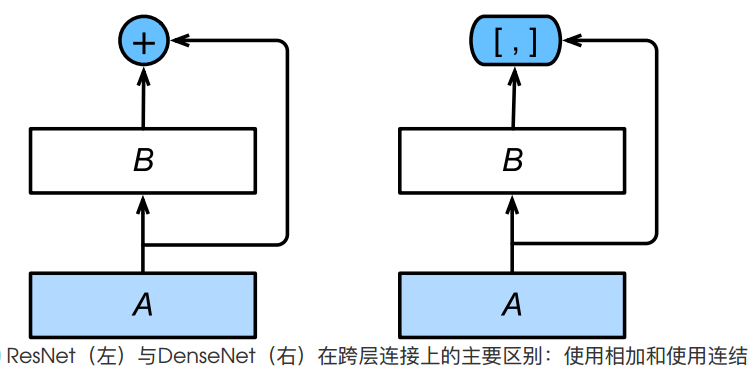

DenseNet 与 ResNet 的主要区别在于:

- 首先,DenseNet ⾥模块的输出不是像 ResNet 那样残差映射 B 和恒等映射 A 相加后输出,⽽是在通道维上将二者连接后输出。

- 其次,在一个 DenseBlock 中,DenseNet 中恒等映射 A 直接和残差映射 B 后的所有层连接在了一起,故称为「稠密连接」。

7.2 PyTorch 实现

1 | |

本博客所有文章除特别声明外,均采用 CC BY-SA 4.0 协议 ,转载请注明出处!